È soprattutto il trasferimento dei dati a causare una grande percentuale di consumo energetico. Questo è ancora di più il caso delle enormi quantità di dati con cui lavorano gli algoritmi di intelligenza artificiale.

L'omissione di questo passaggio, che è anche considerato un collo di bottiglia tra la memoria e i processi logici, ha quindi un impatto enorme. Ed è proprio qui che entra in gioco un'idea del 2003, sviluppata all'epoca presso l'Università del Minnesota.

Questo ha portato a una collaborazione tra numerose discipline, dalla fisica all'ingegneria e all'informatica. Il risultato è stato una serie di circuiti che oggi vengono utilizzati negli orologi intelligenti e negli elementi di memoria.

È stata coinvolta anche la memoria computazionale ad accesso casuale, o CRAM. Questa permette il calcolo effettivo e l'esecuzione di processi paralleli direttamente nella memoria principale e quindi in qualsiasi posizione.

Più che una nuova architettura

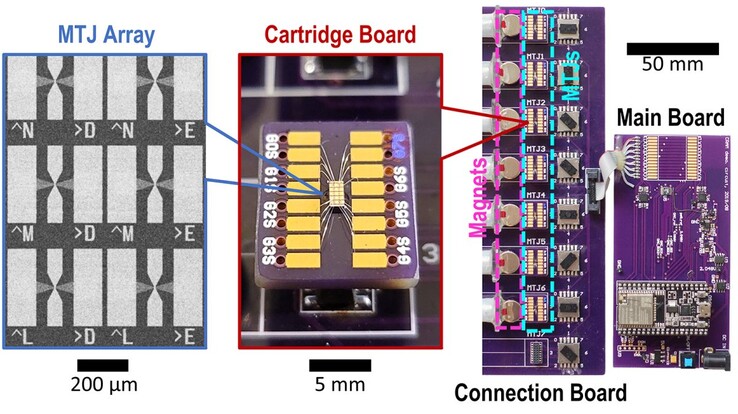

Inoltre, non si tratta di circuiti convenzionali, ma di contatti a tunnel magnetici che possono utilizzare lo spin dell'elettrone invece della carica per passare da 0 a 1.

Nelle applicazioni basate sull'intelligenza artificiale, questo si traduce in un consumo di energia di un millesimo per ottenere alla fine lo stesso risultato del metodo classico. Il consumo di elettricità attuale e previsto delle reti neurali in tutto il mondo mostra quanto sia grande questa quantità di elettricità. Secondo l'Agenzia Internazionale dell'Energia, nel 2022 sono stati utilizzati 460 terawattora. Al più tardi nel 2026, si prevede che saranno 1.000 terawattora.

Con il gigantesco potenziale di risparmio del 99,9%, rimarrebbero 999 terawattora non più necessari. Ciò corrisponde al consumo annuale di elettricità del Giappone, la quarta economia più grande con 126 milioni di abitanti.

Secondo il documento, questo non sarebbe nemmeno il miglior risultato possibile. Ulteriori test potrebbero ridurre il consumo di energia di un fattore 1.700 o 2.500. Questo ulteriore aumento dell'efficienza è reso possibile da un adattamento mirato del CRAM ai singoli algoritmi, che possono essere calcolati ancora più velocemente e quindi in modo più economico.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones