OpenAI ha presentato GPT-4o mini con un prezzo più basso di oltre 25 volte rispetto al GPT-4o, il top della classifica, aprendo l'accesso all'AI di qualità a un maggior numero di aziende e utenti. GPT-4o mini è stato classificato in modo indipendente da tra i primi 10 modelli di AI più capaci oggi disponibili. GPT-4o mini si comporta bene in una serie di benchmark di AI, nonostante sia un modello LLM di piccole dimensioni.

Un modello linguistico di grandi dimensioni (LLM) viene creato dopo l'addestramento su milioni di documenti e costituisce la base per un chatbot AI come ChatGPT. Il modello contiene vettori matematici che associano la probabilità che parole, immagini e altro si verifichino l'una con l'altra. Ad esempio, la probabilità che 'ghiaccio' appaia accanto a 'crema' è molto maggiore di quella che appaia accanto a 'pietra'. Tuttavia, un LLM di grandi dimensioni utilizza molta potenza di calcolo https://arxiv.org/pdf/2210.17331 e energia per rispondere alle richieste degli utenti, il che equivale a un costo elevato per gli utenti. La riduzione degli LLM può renderli più piccoli, più economici e più ecologici, con il compromesso di risposte meno accurate.

I lettori che non sanno come utilizzare l'AI per svolgere meglio le attività aziendali o per guadagnare di più, possono leggere questo libro su Amazon.

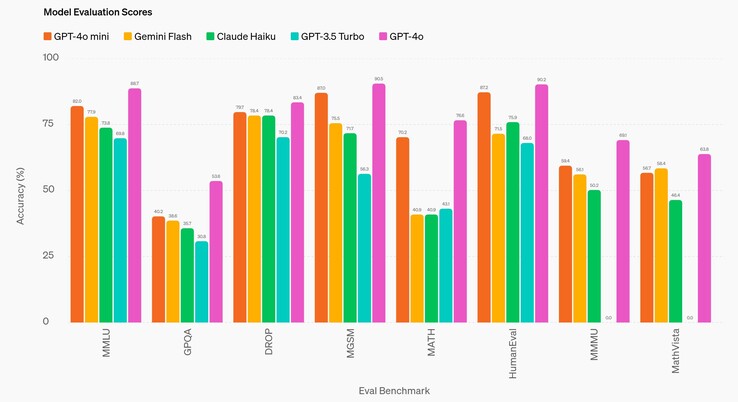

In un confronto diretto con GPT-4o, il miglior LLM di OpenAI rilasciato nel 2024, GPT-4o mini produce costantemente risposte meno accurate. Rispetto a GPT-3.5 Turbo del 2022, GPT-4o mini ha prestazioni migliori. Su una serie di benchmark di AI di livello universitario (DROPHumanEval, MATH, MathVista, MGSM, MMLUe MMMU), il modello risponde alle domande in modo accurato circa il 60-80% delle volte. Solo nel test di dottorato (GPQA) che la sua accuratezza scende a circa il 40%, ovvero solo leggermente meglio di un non esperto che cerca una risposta online.

È importante notare che, mentre GPT-4o ha un prezzo di 5 dollari/1M di token in ingresso e 15 dollari/1M di token in uscita, GPT-4o mini ha un prezzo di 0,15 dollari/1M in ingresso e 0,60 dollari/1M in uscita (1000 token corrispondono a circa 750 parole). Questo è più economico di circa ottanta comuni LLMin uso oggi, ad eccezione di mistral-embed.

GPT-4o mini ha una finestra di contesto di ingresso di 128K token, che è la quantità di testo che può essere analizzata in una sola volta, quindi l'analisi di grandi volumi di documenti aziendali e legali è limitata. La finestra di output è limitata a 16K token. Il modello ha anche un cutoff di conoscenza di ottobre 2023, quindi le notizie, gli eventi e le scoperte che si verificano dopo questa data sono sconosciuti all'AI e non possono essere utilizzati per rispondere alle richieste.

I lettori che stanno ancora aspettando che i robot umanoidi AI vengano puliti e cucinino per loro, come il prototipo prototipo 1X Neodovranno accontentarsi di robot non IA(come questo aspirapolvere su Amazon) nel frattempo.

18 luglio 2024

GPT-4o mini: un'intelligenza efficiente dal punto di vista dei costi

Presentiamo il nostro modello piccolo più efficiente dal punto di vista dei costi

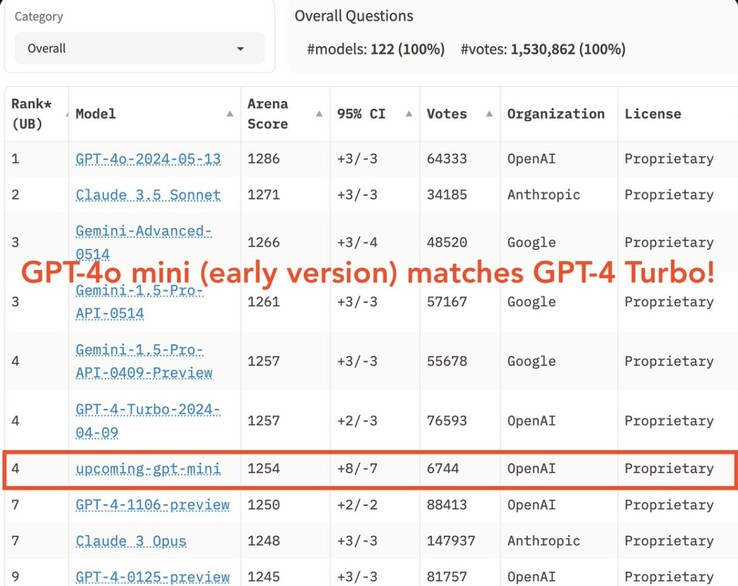

OpenAI si impegna a rendere l'intelligenza il più possibile accessibile. Oggi annunciamo il GPT-4o mini, il nostro modello piccolo più economico. Prevediamo che GPT-4o mini amplierà in modo significativo la gamma di applicazioni costruite con l'AI, rendendo l'intelligenza molto più accessibile. GPT-4o mini ottiene un punteggio dell'82% su MMLU e attualmente supera GPT-41 sulle preferenze di chat nella classifica LMSYS (si apre in una nuova finestra). Il prezzo è di 15 centesimi per milione di gettoni di ingresso e 60 centesimi per milione di gettoni di uscita, un ordine di grandezza più conveniente rispetto ai precedenti modelli di frontiera e più del 60% in meno rispetto a GPT-3.5 Turbo.

GPT-4o mini consente un'ampia gamma di attività grazie al suo basso costo e alla sua latenza, come le applicazioni che concatenano o parallelizzano più chiamate al modello (ad esempio, chiamando più API), passano un grande volume di contesto al modello (ad esempio, l'intera base di codice o la cronologia delle conversazioni), o interagiscono con i clienti attraverso risposte testuali veloci e in tempo reale (ad esempio, i chatbot di assistenza clienti).

Oggi, GPT-4o mini supporta il testo e la visione nell'API, con il supporto di ingressi e uscite di testo, immagini, video e audio in arrivo in futuro. Il modello ha una finestra di contesto di 128K token, supporta fino a 16K token di output per richiesta e ha una conoscenza fino a ottobre 2023. Grazie al tokenizer migliorato condiviso con GPT-4o, la gestione del testo non inglese è ora ancora più conveniente.

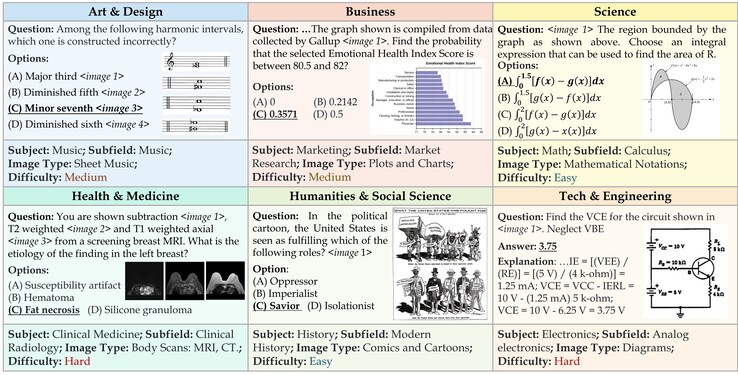

Un modello piccolo con intelligenza testuale superiore e ragionamento multimodale

GPT-4o mini supera GPT-3.5 Turbo e altri modelli di piccole dimensioni nei benchmark accademici, sia per quanto riguarda l'intelligenza testuale che il ragionamento multimodale, e supporta la stessa gamma di lingue di GPT-4o. Dimostra anche ottime prestazioni nelle chiamate di funzione, che possono consentire agli sviluppatori di costruire applicazioni che recuperano dati o intraprendono azioni con sistemi esterni, e prestazioni migliori nel contesto lungo rispetto a GPT-3.5 Turbo.

GPT-4o mini è stato valutato attraverso diversi benchmark chiave2.

Compiti di ragionamento: GPT-4o mini è migliore di altri modelli di piccole dimensioni nei compiti di ragionamento che coinvolgono sia il testo che la visione, con un punteggio dell'82,0% su MMLU, un benchmark di intelligenza testuale e ragionamento, rispetto al 77,9% di Gemini Flash e al 73,8% di Claude Haiku.

Competenza matematica e di codifica: GPT-4o mini eccelle nei compiti di ragionamento matematico e di codifica, superando i precedenti modelli di piccole dimensioni presenti sul mercato. Nell'MGSM, che misura il ragionamento matematico, il GPT-4o mini ha ottenuto l'87,0%, rispetto al 75,5% di Gemini Flash e al 71,7% di Claude Haiku. Il GPT-4o mini ha ottenuto l'87,2% su HumanEval, che misura le prestazioni di codifica, rispetto al 71,5% di Gemini Flash e al 75,9% di Claude Haiku.

Ragionamento multimodale: GPT-4o mini mostra anche una forte performance su MMMU, una valutazione del ragionamento multimodale, con un punteggio del 59,4% rispetto al 56,1% di Gemini Flash e al 50,2% di Claude Haiku.

Come parte del nostro processo di sviluppo del modello, abbiamo lavorato con una manciata di partner fidati per comprendere meglio i casi d'uso e i limiti di GPT-4o mini. Abbiamo collaborato con aziende come Ramp(si apre in una nuova finestra) e Superhuman(si apre in una nuova finestra), che hanno riscontrato che GPT-4o mini ha prestazioni significativamente migliori rispetto a GPT-3.5 Turbo per compiti come l'estrazione di dati strutturati da file di ricevute o la generazione di risposte e-mail di alta qualità quando viene fornita la cronologia dei thread.

Misure di sicurezza integrate

La sicurezza è integrata nei nostri modelli fin dall'inizio e viene rafforzata in ogni fase del nostro processo di sviluppo. Nella fase di pre-formazione, filtriamo (apre in una nuova finestra) le informazioni che non vogliamo che i nostri modelli apprendano o producano, come i discorsi di odio, i contenuti per adulti, i siti che aggregano principalmente informazioni personali e lo spam. Nel post-training, allineiamo il comportamento del modello alle nostre politiche utilizzando tecniche come l'apprendimento con rinforzo e feedback umano (RLHF) per migliorare l'accuratezza e l'affidabilità delle risposte dei modelli.

Il GPT-4o mini ha le stesse mitigazioni di sicurezza integrate nel GPT-4o, che abbiamo valutato attentamente utilizzando valutazioni sia automatizzate che umane, in base al nostro Preparedness Framework e in linea con i nostri impegni volontari. Più di 70 esperti esterni in campi come la psicologia sociale e la disinformazione hanno testato il GPT-4o per identificare i rischi potenziali, che abbiamo affrontato e di cui intendiamo condividere i dettagli nella prossima scheda di sistema del GPT-4o e nella Preparedness scorecard. Le intuizioni di queste valutazioni di esperti hanno contribuito a migliorare la sicurezza del GPT-4o e del GPT-4o mini.

Sulla base di questi insegnamenti, i nostri team hanno anche lavorato per migliorare la sicurezza del GPT-4o mini utilizzando nuove tecniche informate dalla nostra ricerca. GPT-4o mini nell'API è il primo modello ad applicare il nostro metodo di gerarchia delle istruzioni (si apre in una nuova finestra), che aiuta a migliorare la capacità del modello di resistere a jailbreak, iniezioni di prompt ed estrazioni di prompt di sistema. Questo rende le risposte del modello più affidabili e contribuisce a renderlo più sicuro da utilizzare nelle applicazioni su scala.

Continueremo a monitorare l'utilizzo di GPT-4o mini e a migliorare la sicurezza del modello man mano che identificheremo nuovi rischi.

Disponibilità e prezzi

GPT-4o mini è ora disponibile come modello di testo e di visione nelle API Assistenti, API Completamenti Chat e API Batch. Gli sviluppatori pagano 15 centesimi per 1M di token di input e 60 centesimi per 1M di token di output (circa l'equivalente di 2500 pagine di un libro standard). Nei prossimi giorni abbiamo in programma di effettuare una messa a punto per GPT-4o mini.

In ChatGPT, gli utenti Free, Plus e Team potranno accedere a GPT-4o mini a partire da oggi, al posto di GPT-3.5. Anche gli utenti Enterprise avranno accesso a partire dalla prossima settimana, in linea con la nostra missione di rendere i vantaggi dell'AI accessibili a tutti.

Cosa c'è dopo

Negli ultimi anni, abbiamo assistito a notevoli progressi nell'intelligenza artificiale abbinati a riduzioni sostanziali dei costi. Ad esempio, il costo per token di GPT-4o mini è sceso del 99% rispetto a testo-davinci-003, un modello meno capace introdotto nel 2022. Ci impegniamo a continuare questa traiettoria di riduzione dei costi e di miglioramento delle capacità dei modelli.

Prevediamo un futuro in cui i modelli saranno perfettamente integrati in ogni app e in ogni sito web. GPT-4o mini sta aprendo la strada agli sviluppatori per costruire e scalare potenti applicazioni AI in modo più efficiente e conveniente. Il futuro dell'IA sta diventando sempre più accessibile, affidabile e incorporato nelle nostre esperienze digitali quotidiane, e siamo entusiasti di continuare a guidare la strada.

Autore

OpenAI

Riconoscimenti

Responsabili: Jacob Menick, Kevin Lu, Shengjia Zhao, Eric Wallace, Hongyu Ren, Haitang Hu, Nick Stathas, Felipe Petroski Tali

Responsabile del programma: Mianna Chen

Contributi indicati in openai.com/gpt-4o-contributions/

Note a piè di pagina

1

Al 18 luglio 2024, una versione precedente di GPT-4o mini supera GPT-4T 01-25.

2

I numeri di valutazione per GPT-4o mini sono calcolati utilizzando il nostro repo simple-evals(si apre in una nuova finestra) con il prompt dei messaggi dell'assistente API. Per i modelli concorrenti, prendiamo il numero massimo rispetto al loro numero riportato (se disponibile), la classifica HELM(apre una nuova finestra) e la nostra riproduzione tramite simple-evals.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones

![Anche il rilevamento delle impronte digitali di OpenAI si dice che sia accurato al 99,9% (Fonte: OpenAI [modificato])](fileadmin/_processed_/1/6/csm_OpenAI-ChatGPT_c463113f39.jpg)