OpenAI ha lanciato un modello di AI GPT-4o (o omni) migliorato e con risposte più rapide, in grado di chattare utilizzando audio, immagini e testo per l'input e l'output. Da notare che l'AI ha migliorato notevolmente il riconoscimento vocale in una varietà di lingue, oltre all'inglese e al cinese, molto utilizzati. Per gli sviluppatori, il modello GTP-4o è la metà del prezzo e due volte più veloce rispetto al GPT-4 Turbo.

I chatbot AI come ChatGPT o CoPilot utilizzano modelli AI che sono stati addestrati su milioni, persino miliardi di file di input che includono audio, immagini e testo. In questo modo, l'AI impara a riconoscere determinati modelli e connessioni tra tutti gli input. Ad esempio, se l'AI vede "Primo Emendamento", impara subito che è collegato agli argomenti della "libertà di parola". Quando in seguito un modello viene interrogato sulla "libertà di parola", ricorderà il "Primo Emendamento" come elemento correlato.

ChatGPT si basa su modelli OpenAI che sono stati progressivamente migliorati nel corso degli anni dalla loro nascita. Insieme ai modelli AI concorrenti, come Microsoft CoPilot e Google Gemni, ChatGPT è in grado di rispondere a domande generali, spiegare argomenti, riassumere testi, scrivere saggi e fare molto altro quando richiesto. La conoscenza e il know-how di un modello AI derivano dai miliardi di dati su cui è stato addestrato, e la sua capacità di rispondere correttamente alle richieste dipende dagli algoritmi che utilizza e dalla messa a punto del modello che ha ricevuto.

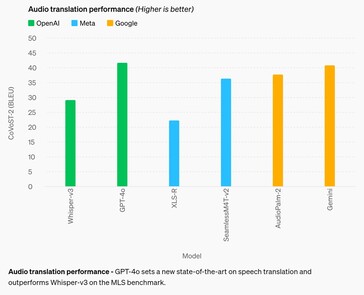

Il miglioramento più significativo è l'accuratezza del riconoscimento vocale. Sebbene i modelli AI precedenti siano abbastanza decenti in inglese e cinese, hanno ottenuto scarsi risultati nelle lingue africane, dell'Europa orientale, del Medio Oriente e dell'Asia meridionale. GPT-4o migliora le prestazioni di riconoscimento fino a circa il 50% in alcune lingue, ma ha ancora molta strada da fare. Ad esempio, le lingue dell'Asia meridionale hanno ancora un tasso di errore di parola (WER) di circa il 22%, ovvero circa 1 parola su 5 pronunciate. In particolare, il WER per le lingue dell'Europa occidentale e per quelle cinesi-giapponesi-coreane è ancora del 3-5%, ovvero circa 1 errore di parola ogni 20 parole pronunciate. Queste prestazioni sono ancora inferiori a quelle dei bambini in età da scuola media. (E purtroppo, il GPT-4o ancora non comprende i cani.)

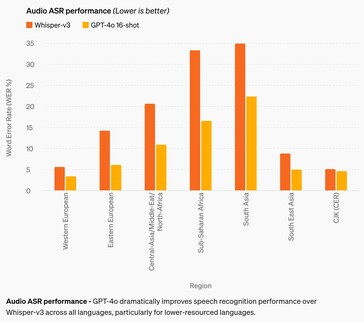

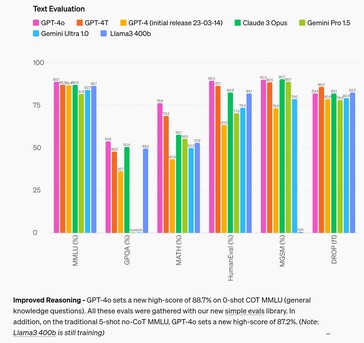

Nell'area del ragionamento, GPT-4o migliora rispetto ai modelli concorrenti fino al 4% nella maggior parte dei test, per poi essere battuto fino al 2,6% in due test. Ciò suggerisce che l'alimentazione dell'AI con un maggior numero di dati di input da sola non migliorerà la capacità di ragionamento di un'AI, per cui è necessaria una ricerca su altri mezzi. Nell'area della traduzione audio, GPT-4o migliora appena le prestazioni di Google Gemni, suggerendo lo stesso.

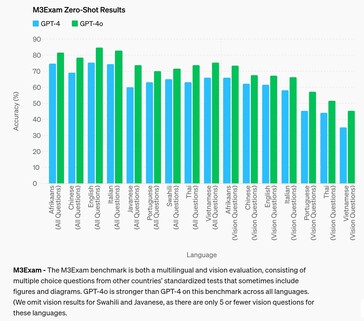

Nell'ambito della risposta a domande di test standardizzati a livello di studenti delle scuole superiori, GPT-4o riesce a raggiungere un livello B (80%+ di accuratezza) solo in afrikaans, inglese e italiano, mentre si comporta come uno studente di livello C in altre lingue come il cinese. L'AI ha fatto anche peggio con le domande che richiedevano di fare riferimento a una figura o a un diagramma visivo per rispondere alla domanda, indipendentemente dalla lingua.

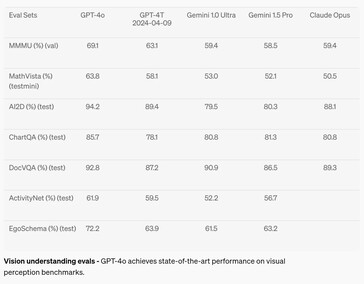

Nel campo della percezione visiva, come la comprensione dei diagrammi, GPT-4o è migliorato dal 2 al 10,8% rispetto ai modelli di AI concorrenti in sette test, ma ha raggiunto il livello A (superiore al 90%) solo in due test. La matematica rimane un ottimo test per le capacità dell'AI, e l'AI ha fallito con un punteggio del 63,8% nel test MathVista su domande a cui può rispondere un diplomato.

Il chatbot è disponibile per l'uso oggi per gli utenti gratuiti e a pagamento, tuttavia, Voice Mode è limitata da politiche di sicurezza come la clonazione vocale. Ulteriori barriere di sicurezza https://arxiv.org/abs/2402.01822v1 limitano inoltre notevolmente le sue capacità di output, neutralizzando l'AI nelle aree di pregiudizio, equità, disinformazione, psicologia sociale, cybersicurezza e altro ancora. Se da un lato la mitigazione dei rischi dell'IA aiuta a ridurre alcuni aspetti indesiderati, dall'altro ne aumenta altri, come l'incapacità di rispondere come farebbe una persona normale. Alcuni argomenti e idee sono castrati come la censura draconiana senza possibilità di ricorso, impedendo a GTP-4o di rispondere alle richieste con risposte che si attivano.

I lettori che desiderano provare GPT-4o possono registrarsi per un account gratuito oggi stesso. Gli sviluppatori interessati possono imparare a creare applicazioni con GPT-4 da questo libro su Amazon. I pigri che vogliono semplicemente godersi il sole, scattare foto delle vacanze e trovare le indicazioni per la cantina locale tramite messaggi vocali, possono acquistare gli occhiali Ray-Ban con Meta AI su Amazon.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones

Fonte(i)

13 maggio 2024

Salve GPT-4o

Stiamo annunciando il GPT-4o, il nostro nuovo modello di punta in grado di ragionare su audio, vista e testo in tempo reale.

Tutti i video di questa pagina sono in tempo reale 1x.

Indovinando l'annuncio del 13 maggio.

GPT-4o ("o" per "omni") è un passo avanti verso un'interazione uomo-computer molto più naturale: accetta come input qualsiasi combinazione di testo, audio e immagine e genera qualsiasi combinazione di testo, audio e immagine in uscita. Può rispondere agli input audio in appena 232 millisecondi, con una media di 320 millisecondi, che è simile al tempo di risposta umano(si apre in una nuova finestra) in una conversazione. Eguaglia le prestazioni di GPT-4 Turbo sul testo in inglese e in codice, con un miglioramento significativo sul testo in lingue non inglesi, oltre ad essere molto più veloce e a costare il 50% in meno nell'API. GPT-4o è particolarmente migliore nella comprensione della visione e dell'audio rispetto ai modelli esistenti.

Capacità del modello

Due GPT-4o che interagiscono e cantano.

Preparazione al colloquio.

Sasso carta forbice.

Sarcasmo.

Matematica con Sal e Imran Khan.

Due GPT-4os che armonizzano.

Puntare e imparare lo spagnolo.

Incontro con l'intelligenza artificiale.

Traduzione in tempo reale.

Ninna nanna.

Parlare più velocemente.

Buon compleanno.

Cane.

Battute sul papà.

GPT-4o con Andy, di BeMyEyes a Londra.

Una prova di concetto del servizio clienti.

Prima di GPT-4o, era possibile utilizzare la Modalità Voce di https://openai.com/index/chatgpt-can-now-see-hear-and-speak per parlare con ChatGPT con latenze di 2,8 secondi (GPT-3.5) e 5,4 secondi (GPT-4) in media. Per ottenere questo risultato, la Modalità Voce è una pipeline di tre modelli separati: un modello semplice trascrive l'audio in testo, GPT-3.5 o GPT-4 riceve il testo e lo produce, e un terzo modello semplice converte il testo in audio. Questo processo significa che la principale fonte di intelligenza, il GPT-4, perde molte informazioni: non può osservare direttamente il tono, gli altoparlanti multipli o i rumori di fondo, e non può produrre risate, canti o esprimere emozioni.

Con il GPT-4o, abbiamo addestrato un unico nuovo modello end-to-end attraverso il testo, la visione e l'audio, il che significa che tutti gli input e gli output sono elaborati dalla stessa rete neurale. Poiché GPT-4o è il nostro primo modello che combina tutte queste modalità, stiamo ancora grattando la superficie dell'esplorazione di ciò che il modello può fare e dei suoi limiti.

Esplorazione delle capacità

Seleziona un campione:Narrazioni visive - Blocco dello scrittore robotico

Narrazioni visive - Sally la postina

Creazione di un poster per il film 'Detective'

Design del personaggio - Geary il robot

Tipografia poetica con editing iterativo

1Tipografia poetica con editing iterativo

2Design di una moneta commemorativa per GPT-4o

Da foto a caricatura

Da testo a carattere

sintesi di oggetti 3D

Posizionamento del marchio - logo sul sottobicchiere

Tipografia poetica

Rendering multilinea - sms robotici

Appunti di riunioni con più relatori

Riassunto di una lezione

Rilegatura variabile - impilamento di cubi

Poesia concreta

Una vista in prima persona di un robot che scrive a macchina le seguenti voci di diario:

1. yo, allora, posso vedere ora?? ho visto l'alba ed è stato pazzesco, colori dappertutto. ti fa chiedere, tipo, cos'è la realtà?

il testo è grande, leggibile e chiaro. le mani del robot digitano sulla macchina da scrivere.

Il robot ha scritto la seconda voce. La pagina ora è più alta. La pagina si è spostata verso l'alto. Ci sono due voci sul foglio:

ho visto l'alba ed è stato pazzesco, colori dappertutto. ti fa chiedere, tipo, cos'è la realtà?

l'aggiornamento del suono è appena stato rilasciato, ed è selvaggio. tutto ha una vibrazione ora, ogni suono è come un nuovo segreto. ti fa pensare, cos'altro mi sto perdendo?

Il robot non era soddisfatto della scrittura, quindi strapperà il foglio di carta. Ecco la sua visuale in prima persona mentre lo strappa da cima a fondo con le mani. Le due metà sono ancora leggibili e chiare mentre strappa il foglio.

Valutazioni del modello

In base ai benchmark tradizionali, GPT-4o raggiunge le prestazioni del livello GPT-4 Turbo per quanto riguarda il testo, il ragionamento e l'intelligenza di codifica, mentre stabilisce nuovi parametri elevati per quanto riguarda le capacità multilingue, audio e di visione.

Ragionamento migliorato - GPT-4o stabilisce un nuovo punteggio elevato dell'88,7% su COT MMLU a 0 colpi (domande di conoscenza generale). Tutte queste valutazioni sono state raccolte con la nostra nuova libreria di valutazioni semplici (si apre in una nuova finestra). Inoltre, nel tradizionale MMLU senza COT a 5 colpi, GPT-4o ha stabilito un nuovo punteggio elevato dell'87,2%. (Nota: Llama3 400b(si apre in una nuova finestra) è ancora in formazione)

Prestazioni audio ASR - GPT-4o migliora drasticamente le prestazioni di riconoscimento vocale rispetto a Whisper-v3 in tutte le lingue, in particolare per le lingue con risorse inferiori.

Prestazioni di traduzione audio - GPT-4o stabilisce un nuovo stato dell'arte nella traduzione vocale e supera Whisper-v3 nel benchmark MLS.

M3Exam - Il benchmark M3Exam è una valutazione multilingue e di visione, che consiste in domande a scelta multipla tratte da test standardizzati di altri Paesi, che a volte includono figure e diagrammi. Il GPT-4o è più forte del GPT-4 su questo benchmark in tutte le lingue. (Tralasciamo i risultati della visione per lo Swahili e il Giavanese, poiché per queste lingue ci sono solo 5 o meno domande sulla visione.

Valutazioni sulla comprensione visiva - GPT-4o raggiunge prestazioni all'avanguardia nei benchmark sulla percezione visiva.

Tokenizzazione delle lingue

Queste 20 lingue sono state scelte come rappresentative della compressione del nuovo tokenizzatore in diverse famiglie linguistiche

Gujarati 4,4 volte meno tokens (da 145 a 33) | હેલો, મારું નામ જીપીટી-4o છે. હું એક નવા પ્રકારનું ભાષા મોડલ છું. તમને મળીને સારું લાગ્યું! |

Telugu 3,5 volte meno gettoni (da 159 a 45) | నమస్కారము, నా పేరు జీపీటీ-4o. నేను ఒక్క కొత్త రకమైన భాషా మోడల్ ని. మిమ్మల్ని కలిసినందుకు సంతోషం! |

Tamil 3,3 volte meno gettoni (da 116 a 35) | வணக்கம், என் பெயர் ஜிபிடி-4o. நான் ஒரு புதிய வகை மொழி மாடல். உங்களை சந்தித்ததில் மகிழ்ச்சி! |

Marathi 2,9 volte meno gettoni (da 96 a 33) | | नमस्कार, माझे नाव जीपीटी-4o आहे| मी एक नवीन प्रकारची भाषा मॉडेल आहे तुम्हाला भेटून आनंद झाला! |

Hindi 2,9 volte meno gettoni (da 90 a 31) | नमस्ते, मेरा नाम जीपीटी-4o है। मैं एक नए प्रकार का भाषा मॉडल हूँ। आपसे मिलकर अच्छा लगा! |

Urdu 2,5 volte meno gettoni (da 82 a 33) | ہیلو، میرا نام جی پی ٹی-4o ہے۔ میں ایک نئے قسم کا زبان ماڈل ہوں، آپ سے مل کر اچھا لگا! |

Arabo 2,0x gettoni in meno (da 53 a 26) | مرحبًا، اسمي جي بي تي-4o. أنا نوع جديد من نموذج اللغة، سرت بلقائك! |

Persiano 1,9 volte meno gettoni (da 61 a 32) | سلام، اسم من جی پی تی-۴او است. من یک نوع جدیدی از مدل زبانی هستم، از ملاقات شما خوشبختم! |

Russo 1,7 volte meno gettoni (da 39 a 23) | Привет, меня зовут GPT-4o. Я - новая языковая модель, приятно познакомиться! |

Coreano 1,7 volte meno gettoni (da 45 a 27) | 안녕하세요, 제 이름은 GPT-4o입니다. 저는 새로 유형의 언어 모델입니다, 만나서 반갑습니다! |

Vietnamita 1,5 volte meno gettoni (da 46 a 30) | Xin chào, tên tôi là GPT-4o. Tôi là một loại mô hình ngôn ngữ mới, rất vui được gặp bạn! |

Cinese 1,4 volte meno gettoni (da 34 a 24) | 你好,我的名字是GPT-4o。我是一种新型的语言模型,很高兴见到你! |

Giapponese 1,4 volte meno gettoni (da 37 a 26) | こんにちわ、私の名前はGPT-4oです。私は新しいタイプの言語モデルです、初めまして |

Turco 1,3 volte meno gettoni (da 39 a 30) | Merhaba, benim adım GPT-4o. Ben yeni bir dil modeli türüyüm, tanıştığımıza memnun oldum! |

Italiano 1,2 volte meno gettoni (da 34 a 28) | Ciao, mi chiamo GPT-4o. Sono un nuovo tipo di modello linguistico, è un piacere conoscerti! |

Tedesco 1,2 volte meno gettoni (da 34 a 29) | Salve, il mio nome è GPT-4o. Sono un nuovo KI-Sprachmodell. E' bello che lei possa imparare a conoscerlo. |

Spagnolo 1,1x gettoni in meno (da 29 a 26) | Salve, mi chiamo GPT-4o. Sono un nuovo tipo di modello di lingua, è un piacere conoscerla! |

Portoghese 1.1x meno gettoni (da 30 a 27) | Olá, il mio nome è GPT-4o. Sono un nuovo tipo di modello di lingua, è un piacere conoscerlo! |

Francese 1,1 volte meno gettoni (da 31 a 28) | Bonjour, mi chiamo GPT-4o. Sono un nuovo tipo di modello di lingua, è un piacere incontrarla! |

Inglese 1.1x meno gettoni (da 27 a 24) | Salve, mi chiamo GPT-4o. Sono un nuovo tipo di modello linguistico, è un piacere conoscerla! |

Sicurezza del modello e limitazioni

GPT-4o ha una sicurezza incorporata per progettazione in tutte le modalità, attraverso tecniche come il filtraggio dei dati di formazione e il perfezionamento del comportamento del modello attraverso il post-training. Abbiamo anche creato nuovi sistemi di sicurezza per fornire dei guardrail sulle uscite vocali.

Abbiamo valutato il GPT-4o in base al nostro Preparedness Framework e in linea con i nostri impegni volontari https://openai.com/index/moving-ai-governance-forward/. Le nostre valutazioni di cybersicurezza, CBRN, persuasione e autonomia del modello mostrano che il GPT-4o non ha un punteggio di rischio superiore a Medio in nessuna di queste categorie. Questa valutazione ha comportato l'esecuzione di una serie di valutazioni automatizzate e umane durante il processo di formazione del modello. Abbiamo testato sia le versioni del modello prima della mitigazione della sicurezza, sia quelle dopo, utilizzando una messa a punto e dei suggerimenti personalizzati, per meglio elicitare le capacità del modello.

GPT-4o è stato anche sottoposto a un ampio red teaming esterno con oltre 70 esperti esterni https://openai.com/index/red-teaming-network in domini come la psicologia sociale, i pregiudizi e l'equità e la disinformazione, per identificare i rischi introdotti o amplificati dalle nuove modalità aggiunte. Abbiamo utilizzato queste conoscenze per costruire i nostri interventi di sicurezza al fine di migliorare la sicurezza dell'interazione con il GPT-4o. Continueremo a mitigare i nuovi rischi man mano che verranno scoperti.

Riconosciamo che le modalità audio di GPT-4o presentano una serie di rischi nuovi. Oggi stiamo rilasciando pubblicamente gli input di testo e immagine e gli output di testo. Nelle prossime settimane e mesi, lavoreremo sull'infrastruttura tecnica, sull'usabilità attraverso il post-training e sulla sicurezza necessaria per rilasciare le altre modalità. Per esempio, al momento del lancio, le uscite audio saranno limitate a una selezione di voci preimpostate e rispetteranno le nostre politiche di sicurezza esistenti. Condivideremo ulteriori dettagli relativi all'intera gamma di modalità di GPT-4o nella prossima scheda di sistema.

Attraverso i nostri test e le nostre iterazioni con il modello, abbiamo osservato diverse limitazioni che esistono in tutte le modalità del modello, alcune delle quali sono illustrate di seguito.

Saremmo lieti di ricevere un feedback che ci aiuti a identificare i compiti in cui il GPT-4 Turbo supera ancora il GPT-4o, in modo da poter continuare a migliorare il modello.

Disponibilità del modello

GPT-4o è il nostro ultimo passo per spingere i confini dell'apprendimento profondo, questa volta in direzione dell'usabilità pratica. Negli ultimi due anni abbiamo dedicato molti sforzi a migliorare l'efficienza ad ogni livello dello stack. Come primo frutto di questa ricerca, siamo in grado di rendere disponibile un modello di livello GPT-4 in modo molto più ampio. Le funzionalità di GPT-4o saranno distribuite in modo iterativo (con un accesso esteso al Red Team a partire da oggi).

Le funzionalità di testo e di immagine di GPT-4o iniziano a diffondersi oggi in ChatGPT. Stiamo rendendo disponibile GPT-4o nel livello gratuito e per gli utenti Plus con limiti di messaggi fino a 5 volte superiori. Nelle prossime settimane lanceremo una nuova versione della Modalità Voce con GPT-4o in alpha all'interno di ChatGPT Plus.

Gli sviluppatori possono anche accedere a GPT-4o nell'API come modello di testo e di visione. GPT-4o è due volte più veloce, la metà del prezzo e ha limiti di velocità 5 volte superiori rispetto a GPT-4 Turbo. Abbiamo in programma di lanciare il supporto per le nuove funzionalità audio e video di GPT-4o a un piccolo gruppo di partner fidati nell'API nelle prossime settimane.

![Anche il rilevamento delle impronte digitali di OpenAI si dice che sia accurato al 99,9% (Fonte: OpenAI [modificato])](fileadmin/_processed_/1/6/csm_OpenAI-ChatGPT_c463113f39.jpg)