OpenAI ha presentato il suo ultimo modello linguistico AI di grandi dimensioni, o3-mini, che è più veloce e migliore del suo predecessore o1-mini nel fornire risposte accurate. Questo modello è il primo LLM di ragionamento piccolo dell'azienda, disponibile per l'uso pubblico gratuito da parte di tutti i titolari di un account ChatGPT.

Il modello o3-mini può essere eseguito utilizzando tre livelli di sforzo di ragionamento: basso, medio e alto. Chiunque abbia un account ChatGPT gratuito può eseguire o3-mini gratuitamente al livello di ragionamento medio, mentre i titolari di un account a pagamento possono scegliere i livelli di ragionamento basso o alto. Gli utenti a pagamento di ChatGPT Plus, Team e Pro hanno accesso immediato a o3-mini oggi, mentre gli utenti Enterprise devono aspettare fino a febbraio. I programmatori che non vedono l'ora di creare applicazioni da classifica basate sull'API OpenAI o3-mini possono leggere come farlo con questo libro su Amazon.

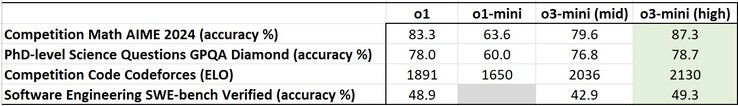

In generale, o3-mini, quando è impostato sulla modalità di ragionamento media o alta, supera o1-mini nei benchmark di AI standardizzati, compresi quelli che richiedono all'AI di ragionare sui problemi. Quando è impostato sulla modalità di ragionamento alta, o3-mini riesce anche a superare il modello più grande o1 in alcuni benchmark, ma non ha la capacità di o1 di vedere le immagini ed elaborare i dati visivi.

In particolare, o3-mini fornisce risposte il 24%, ossia circa 2,46 secondi, più velocemente di o1-mini. Ciò contribuisce a ridurre il tempo di attesa di ChatGPT per fornire le risposte e le emissioni di carbonio prodotte dai computer che eseguono o3-mini. Sebbene sia più veloce, gli hacker saranno delusi da o3-mini perché la sua capacità di essere utilizzato per gli attacchi di cybersicurezza è stata notevolmente ridotta.

31 gennaio 2025

OpenAI o3-mini

Spingiamo la frontiera del ragionamento economico.

Stiamo rilasciando OpenAI o3-mini, il modello più recente ed economico della nostra serie di ragionamenti, disponibile oggi sia in ChatGPT che nell'API. Presentato in anteprima a dicembre 2024, questo modello potente e veloce avanza i confini di ciò che i modelli di piccole dimensioni possono raggiungere, offrendo eccezionali capacità STEM - con particolare forza nelle scienze, nella matematica e nella codifica - il tutto mantenendo il basso costo e la latenza ridotta di OpenAI o1-mini.

OpenAI o3-mini è il nostro primo modello di ragionamento di piccole dimensioni che supporta le funzionalità altamente richieste dagli sviluppatori, tra cui la chiamata di funzioni(si apre in una nuova finestra), gli output strutturati(si apre in una nuova finestra) e i messaggi degli sviluppatori(si apre in una nuova finestra), rendendolo pronto per la produzione fin dall'inizio. Come OpenAI o1-mini e OpenAI o1-preview, o3-mini supporterà lo streaming(si apre in una nuova finestra). Inoltre, gli sviluppatori possono scegliere tra tre opzioni di sforzo di ragionamento(si apre in una nuova finestra) - basso, medio e alto - per ottimizzare i loro casi d'uso specifici. Questa flessibilità consente a o3-mini di "pensare più intensamente" quando si affrontano sfide complesse o di dare priorità alla velocità quando la latenza è un problema. o3-mini non supporta le funzionalità di visione, pertanto gli sviluppatori devono continuare ad utilizzare OpenAI o1 per le attività di ragionamento visivo. o3-mini è in fase di lancio nelle API di completamento della chat, nelle API degli assistenti e nelle API Batch a partire da oggi per alcuni sviluppatori selezionati nei livelli di utilizzo delle API 3-5(si apre in una nuova finestra).

Gli utenti di ChatGPT Plus, Team e Pro possono accedere a OpenAI o3-mini a partire da oggi, mentre l'accesso Enterprise arriverà a febbraio. o3-mini sostituirà OpenAI o1-mini nel model picker, offrendo limiti di velocità più elevati e una latenza più bassa, rendendolo una scelta convincente per le attività di codifica, STEM e di risoluzione di problemi logici. Come parte di questo aggiornamento, stiamo triplicando il limite di velocità per gli utenti Plus e Team, da 50 messaggi al giorno con o1-mini a 150 messaggi al giorno con o3-mini. Inoltre, o3-mini ora funziona con la ricerca per trovare risposte aggiornate con link a fonti web pertinenti. Si tratta di un prototipo iniziale, in quanto lavoriamo per integrare la ricerca nei nostri modelli di ragionamento.

A partire da oggi, gli utenti del piano gratuito possono anche provare OpenAI o3-mini selezionando 'Ragiona' nel compositore di messaggi o rigenerando una risposta. Questa è la prima volta che un modello di ragionamento viene messo a disposizione degli utenti gratuiti in ChatGPT.

Mentre OpenAI o1 rimane il nostro modello di ragionamento di conoscenza generale più ampio, OpenAI o3-mini offre un'alternativa specializzata per i domini tecnici che richiedono precisione e velocità. In ChatGPT, o3-mini utilizza uno sforzo di ragionamento medio per fornire un compromesso equilibrato tra velocità e precisione. Tutti gli utenti a pagamento avranno anche la possibilità di selezionare o3-mini-high nel selezionatore di modelli per una versione di intelligenza superiore che richiede un po' più di tempo per generare risposte. Gli utenti Pro avranno accesso illimitato sia a o3-mini che a o3-mini-high.

Veloce, potente e ottimizzato per il ragionamento STEM

Come il suo predecessore OpenAI o1, OpenAI o3-mini è stato ottimizzato per il ragionamento STEM. o3-mini, con uno sforzo di ragionamento medio, eguaglia le prestazioni di o1 in matematica, codifica e scienze, fornendo risposte più veloci. Le valutazioni di tester esperti hanno dimostrato che o3-mini produce risposte più precise e chiare, con capacità di ragionamento più forti, rispetto a OpenAI o1-mini. I tester hanno preferito le risposte di o3-mini a quelle di o1-mini nel 56% dei casi e hanno osservato una riduzione del 39% degli errori principali su domande difficili del mondo reale. Con uno sforzo di ragionamento medio, o3-mini eguaglia le prestazioni di o1 in alcune delle valutazioni di ragionamento e intelligenza più impegnative, tra cui AIME e GPQA.

Competizione matematica (AIME 2024)

Il grafico a barre confronta l'accuratezza delle domande di matematica della competizione AIME 2024 tra i modelli AI. I modelli più vecchi (grigi) ottengono punteggi inferiori, mentre quelli più recenti (gialli) migliorano. "o3-mini (high)" raggiunge l'accuratezza più alta all'83,6%, mostrando un progresso significativo.

Matematica: Con un basso sforzo di ragionamento, OpenAI o3-mini raggiunge prestazioni paragonabili a OpenAI o1-mini, mentre con uno sforzo medio, o3-mini raggiunge prestazioni paragonabili a o1. Nel frattempo, con uno sforzo di ragionamento elevato, o3-mini supera sia OpenAI o1-mini che OpenAI o1, dove le regioni ombreggiate in grigio mostrano le prestazioni del voto di maggioranza (consenso) con 64 campioni.

Domande scientifiche a livello di dottorato (GPQA Diamond)

Il grafico a barre confronta l'accuratezza delle domande scientifiche di livello PhD (GPQA Diamond) tra i modelli di AI. I modelli più vecchi (grigio) hanno prestazioni inferiori, mentre quelli più recenti (giallo) migliorano. "o3-mini (high)" raggiunge il 77,0% di accuratezza, mostrando un notevole progresso rispetto alle versioni precedenti.

Scienza di livello PhD: Nelle domande di biologia, chimica e fisica di livello PhD, con un basso sforzo di ragionamento, OpenAI o3-mini raggiunge prestazioni superiori a OpenAI o1-mini. Con uno sforzo elevato, o3-mini raggiunge prestazioni paragonabili a quelle di o1.

FrontierMath

Una griglia nera con più righe e colonne, separate da sottili linee bianche, che creano un layout strutturato e organizzato.

Matematica a livello di ricerca: OpenAI o3-mini con un ragionamento elevato ottiene prestazioni migliori rispetto al suo predecessore su FrontierMath. Su FrontierMath, quando viene richiesto di utilizzare uno strumento Python, o3-mini con elevato sforzo di ragionamento risolve oltre il 32% dei problemi al primo tentativo, compreso oltre il 28% dei problemi impegnativi (T3). Questi numeri sono provvisori, e il grafico sopra mostra le prestazioni senza strumenti o calcolatrice.

Codice della competizione (Codeforces)

Il grafico a barre confronta le valutazioni Elo sui compiti di codifica della competizione Codeforces tra i modelli AI. I modelli più vecchi (grigi) ottengono punteggi più bassi, mentre quelli più recenti (gialli) migliorano. "o3-mini (high)" raggiunge 2073 Elo, mostrando un progresso significativo rispetto alle versioni precedenti.

Competizione di codifica: Nella programmazione competitiva di Codeforces, OpenAI o3-mini raggiunge punteggi Elo progressivamente più alti con l'aumento dello sforzo di ragionamento, superando sempre o1-mini. Con uno sforzo di ragionamento medio, eguaglia le prestazioni di o1.

Ingegneria del software (SWE-bench verificato)

Il grafico a barre confronta l'accuratezza sui compiti di ingegneria del software SWE-bench Verified tra i modelli AI. I modelli più vecchi (in grigio) hanno prestazioni inferiori, mentre "o3-mini (alto)" (giallo) raggiunge l'accuratezza più alta con il 48,9%, mostrando un miglioramento rispetto alle versioni precedenti.

Ingegneria del software: o3-mini è il nostro modello più performante rilasciato su SWEbench-verificato. Per ulteriori dati sui risultati di SWE-bench Verified con un elevato sforzo di ragionamento, anche con lo scaffold Agentless open-source (39%) e con uno scaffold di strumenti interni (61%), consulti la nostra scheda di sistema.

LiveBench Coding

La tabella confronta i modelli AI sui compiti di codifica, mostrando le metriche di prestazione e i punteggi di valutazione. Evidenzia le differenze in termini di precisione ed efficienza, con alcuni modelli che superano altri in benchmark specifici.

Codifica LiveBench: OpenAI o3-mini supera o1-high anche con uno sforzo di ragionamento medio, evidenziando la sua efficienza nei compiti di codifica. Con uno sforzo di ragionamento elevato, o3-mini estende ulteriormente il suo vantaggio, ottenendo prestazioni significativamente più forti nelle metriche chiave.

Conoscenze generali

La tabella intitolata "Valutazioni di categoria" confronta i modelli AI tra le diverse categorie di valutazione, mostrando le metriche di prestazione. Evidenzia le differenze in termini di precisione, efficienza ed efficacia, con alcuni modelli che superano altri in compiti specifici.

Conoscenza generale: o3-mini supera o1-mini nelle valutazioni della conoscenza nei domini di conoscenza generale.

Valutazione delle preferenze umane

Il grafico confronta le percentuali di vittoria per i compiti STEM e non STEM tra i modelli AI. "o3_mini_v43_s960_j128" (giallo) supera "o1_mini_chatgpt" (linea di base rossa) in entrambe le categorie, con un tasso di vittoria più alto per i compiti STEM.

Il grafico confronta le percentuali di vittoria sotto vincoli di tempo e le percentuali di errore maggiore tra i modelli AI. "o3_mini_v43_s960_j128" (giallo) supera "o1_mini_chatgpt" (linea di base rossa) nella percentuale di vittorie e riduce significativamente gli errori gravi.

Valutazione delle preferenze umane: Anche le valutazioni di tester esterni esperti mostrano che OpenAI o3-mini produce risposte più accurate e chiare, con capacità di ragionamento più forti rispetto a OpenAI o1-mini, soprattutto per le materie STEM. I tester hanno preferito le risposte di o3-mini a quelle di o1-mini nel 56% dei casi e hanno osservato una riduzione del 39% degli errori principali su domande difficili del mondo reale.

Velocità e prestazioni del modello

Con un'intelligenza paragonabile a quella di OpenAI o1, OpenAI o3-mini offre prestazioni più veloci e una maggiore efficienza. Oltre alle valutazioni STEM evidenziate sopra, o3-mini dimostra risultati superiori in ulteriori valutazioni matematiche e di fattualità con uno sforzo di ragionamento medio. Nei test A/B, o3-mini ha fornito risposte più veloci del 24% rispetto a o1-mini, con un tempo medio di risposta di 7,7 secondi rispetto a 10,16 secondi.

Confronto di latenza tra o1-mini e o3-mini (medio)

Il grafico a barre confronta la latenza tra i modelli "o1-mini" e "o3-mini (medio)". "o3-mini" (giallo più chiaro) ha una latenza più bassa, che indica tempi di risposta più rapidi, mentre "o1-mini" (giallo più scuro) richiede in media più tempo.

Latenza: o3-mini ha un tempo medio di 2500 ms più veloce per il primo token rispetto a o1-mini.

Sicurezza

Una delle tecniche chiave che abbiamo utilizzato per insegnare a OpenAI o3-mini a rispondere in modo sicuro è l'allineamento deliberativo, in cui abbiamo addestrato il modello a ragionare sulle specifiche di sicurezza scritte dall'uomo prima di rispondere alle richieste dell'utente. Come OpenAI o1, troviamo che o3-mini supera in modo significativo GPT-4o nelle valutazioni di sicurezza e jailbreak. Prima della distribuzione, abbiamo valutato attentamente i rischi di sicurezza di o3-mini, utilizzando lo stesso approccio alla preparazione, al red-teaming esterno e alle valutazioni di sicurezza di o1. Ringraziamo i tester di sicurezza che hanno richiesto di testare o3-mini in accesso anticipato. I dettagli delle valutazioni che seguono, insieme ad una spiegazione completa dei rischi potenziali e dell'efficacia delle nostre mitigazioni, sono disponibili nella scheda di sistema di o3-mini.

Valutazioni dei contenuti non consentiti

La tabella confronta i modelli di AI sulle metriche di sicurezza, valutando le prestazioni nelle diverse categorie di rischio. Evidenzia le variazioni nella conformità alla sicurezza, con alcuni modelli che hanno prestazioni migliori nel ridurre i rischi potenziali.

Valutazioni sul Jailbreak

La tabella confronta i modelli di intelligenza artificiale sulle metriche di sicurezza attraverso diverse categorie di rischio, mostrando le variazioni di performance. Evidenzia le differenze nella mitigazione dei rischi, con alcuni modelli che dimostrano una maggiore conformità e risposte più sicure.

Il prossimo passo

Il rilascio di OpenAI o3-mini segna un altro passo nella missione di OpenAI di spingere i confini dell'intelligenza economica. Ottimizzando il ragionamento per i settori STEM e mantenendo i costi bassi, stiamo rendendo l'AI di alta qualità ancora più accessibile. Questo modello continua il nostro percorso di riduzione del costo dell'intelligenza - riducendo i prezzi per token del 95% dal lancio di GPT-4 - pur mantenendo capacità di ragionamento di alto livello. Con l'espansione dell'adozione dell'AI, continuiamo ad impegnarci per essere all'avanguardia, costruendo modelli che bilanciano intelligenza, efficienza e sicurezza su scala.

Gli autori

OpenAI

Formazione

Brian Zhang, Eric Mitchell, Hongyu Ren, Kevin Lu, Max Schwarzer, Michelle Pokrass, Shengjia Zhao, Ted Sanders

Valutazione

Adam Kalai, Alex Tachard Passos, Ben Sokolowsky, Elaine Ya Le, Erik Ritter, Hao Sheng, Hanson Wang, Ilya Kostrikov, James Lee, Johannes Ferstad, Michael Lampe, Prashanth Radhakrishnan, Sean Fitzgerald, Sebastien Bubeck, Yann Dubois, Yu Bai

Evali di frontiera e preparazione

Andy Applebaum, Elizabeth Proehl, Evan Mays, Joel Parish, Kevin Liu, Leon Maksin, Leyton Ho, Miles Wang, Michele Wang, Olivia Watkins, Patrick Chao, Samuel Miserendino, Tejal Patwardhan

Ingegneria

Adam Walker, Akshay Nathan, Alyssa Huang, Andy Wang, Ankit Gohel, Ben Eggers, Brian Yu, Bryan Ashley, Chengdu Huang, Christian Hoareau, Davin Bogan, Emily Sokolova, Eric Horacek, Eric Jiang, Felipe Petroski Such, Jonah Cohen, Josh Gross, Justin Becker, Kan Wu, Kevin Whinnery, Larry Lv, Lee Byron, Manoli Liodakis, Max Johnson, Mike Trpcic, Murat Yesildal, Rasmus Rygaard, RJ Marsan, Rohit Ramchandani, Rohan Kshirsagar, Roman Huet, Sara Conlon, Shuaiqi (Tony) Xia, Siyuan Fu, Srinivas Narayanan, Sulman Choudhry, Tomer Kaftan, Trevor Creech

Ricerca

Adam Fry, Adam Perelman, Brandon Wang, Cristina Scheau, Philip Pronin, Sundeep Tirumalareddy, Will Ellsworth, Zewei Chu

Prodotto

Antonia Woodford, Beth Hoover, Jake Brill, Kelly Stirman, Minnia Feng, Neel Ajjarapu, Nick Turley, Nikunj Handa, Olivier Godement

Sicurezza

Andrea Vallone, Andrew Duberstein, Enis Sert, Eric Wallace, Grace Zhao, Irina Kofman, Jieqi Yu, Joaquin Quinonero Candela, Madelaine Boyd, Mehmet Yatbaz, Mike McClay, Mingxuan Wang, Saachi Jain, Sandhini Agarwal, Sam Toizer, Santiago Hernández, Steve Mostovoy, Young Cha, Tao Li, Yunyun Wang

Redteaming esterno

Lama Ahmad, Troy Peterson

Responsabili del programma di ricerca

Carpus Chang, Kristen Ying

Leadership

Aidan Clark, Dane Stuckey, Jerry Tworek, Jakub Pachocki, Johannes Heidecke, Kevin Weil, Liam Fedus, Mark Chen, Sam Altman, Wojciech Zaremba

+ tutti i collaboratori di o1.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones