Gli ingegneri dello Stanford Computational Imaging Lab hanno sviluppato un prototipo di occhiali AR leggeri, aprendo la strada a futuri occhiali AR olografici che saranno significativamente più leggeri delle cuffie attualmente disponibili. Un display guidato dall'intelligenza artificiale che proietta un'immagine 3D senza utilizzare lenti ingombranti attraverso due metasuperfici all'interno di una sottile guida d'onda ottica è la chiave di questa innovazione.

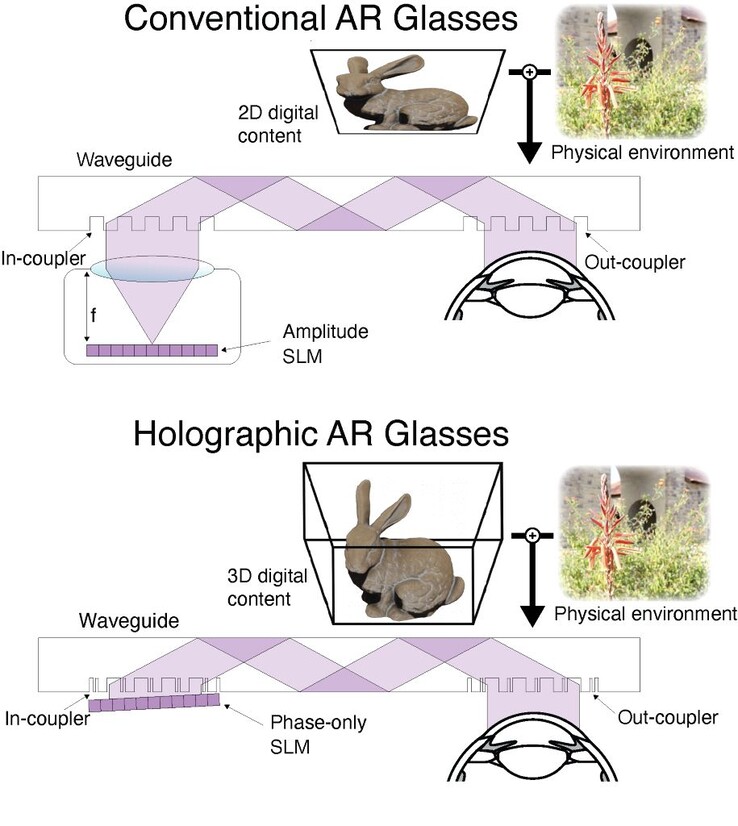

Le cuffie AR/VR/XR convenzionali utilizzano in genere lenti di messa a fuoco per proiettare immagini di display micro LED o OLED negli occhi di chi le indossa. Purtroppo, la profondità richiesta per le lenti porta a design ingombranti, come gli smartphone in Google Cardboard o i dispositivi Apple Vision Pro che pesano più di 600 grammi.

I modelli più sottili a volte utilizzano una guida d'onda ottica (si pensi a un periscopio) per spostare il display e le lenti da davanti agli occhi al lato della testa, ma limitano l'utente a immagini e testi 2D. Gli ingegneri di Stanford hanno combinato la tecnologia AI con le guide d'onda metasuperficiali per ridurre il peso e l'ingombro delle cuffie AR, proiettando al contempo un'immagine olografica 3D.

La prima innovazione è l'eliminazione delle ingombranti lenti di messa a fuoco. Invece, le metasuperfici ultrafini incise nella guida d'onda 'codificano' e poi 'decodificano' un'immagine proiettata piegando e allineando la luce. In modo molto approssimativo, si può pensare che sia come spruzzare l'acqua a un'estremità di una piscina secondo un ritmo prestabilito e, quando le onde raggiungono l'altra estremità, si possono leggere le onde per ricreare il ritmo originale. Gli occhiali di Stanford utilizzano una metasuperficie davanti al display e un'altra davanti all'occhio.

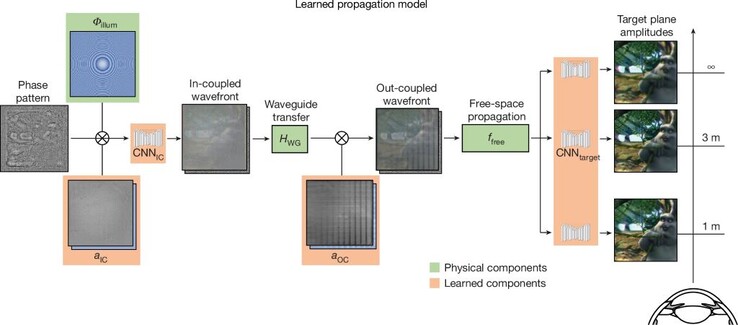

Il secondo è un modello di propagazione della guida d'onda per simulare come la luce rimbalza attraverso la guida d'onda per creare immagini olografiche in modo accurato. le olografie 3D dipendono molto dall'accuratezza della trasmissione della luce, e anche variazioni nanometriche nelle superfici della guida d'onda possono alterare notevolmente l'immagine olografica vista. Qui, le reti neurali di convoluzione ad apprendimento profondo che utilizzano un'architettura UNet modificata https://arxiv.org/abs/1505.04597 sono addestrate sulla luce rossa, verde e blu inviata attraverso la guida d'onda per compensare le aberrazioni ottiche del sistema. In poche parole, si pensi a una freccia che punta all'occhio di bue, ma che colpisce solo un po' a destra: ora si sa che bisogna compensare puntando un po' a sinistra.

Il terzo è l'uso di una rete neurale AI per creare immagini olografiche. UN 48 GB Nvidia RTX A6000 da 48 GB è stato utilizzato per addestrare l'intelligenza artificiale su un'ampia gamma di modelli di fase proiettati dal modulo di visualizzazione Holoeye Leto-3 modulo di visualizzazione SLM a sola fase. Nel corso del tempo, l'intelligenza artificiale ha imparato quali modelli potevano creare immagini specifiche a quattro distanze (1 m, 1,5 m, 3 m e infinito).

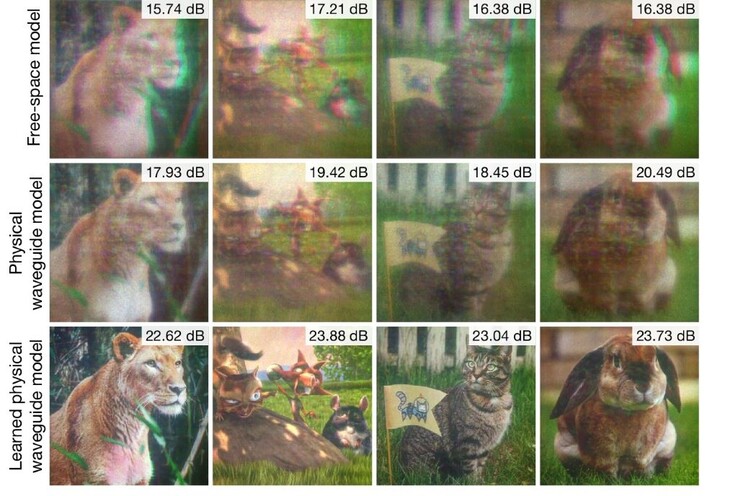

Nel complesso, il modello AI che alimenta questo auricolare produce immagini 3D significativamente migliori rispetto alle alternative. Sebbene gli occhiali AR di Stanford siano un prototipo, i lettori possono comunque godersi il mondo aumentato oggi con un auricolare leggero come questo su Amazon.

Fonte(i)

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones