La scorsa settimana, i ricercatori di Apple hanno presentato OpenELM, una serie di " modelli linguistici efficientiopen-source", sulla libreria di modelli Hugging Face. Le quattro varianti hanno dimensioni che vanno da 270 milioni di parametri a 3 miliardi e sono i candidati più probabili per l'AI on-device per i dispositivi Apple.

Per avere un contesto, Apple ha lanciato in sordina un framework di apprendimento automatico chiamato MLX nel dicembre 2023. Successivamente è stato lanciato MLLM-Guided Image Editing (MGIE)seguito da una serie di iniziative di AI generativa, tra cui Keyframer, Ferret-UI e Il completamento del codice AI in Xcode. Per la maggior parte, questi progetti sfruttano la potenza di elaborazione del silicio di Apple piuttosto che scaricare la funzionalità AI nel cloud.

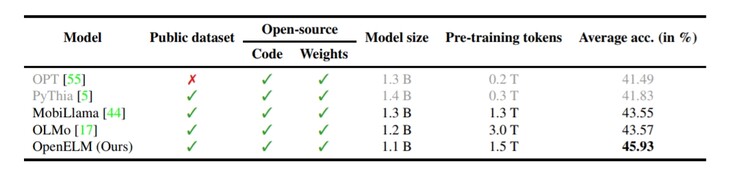

Allo stesso modo, OpenELM rappresenta l'approccio on-device di Apple all'AI. In genere, gli LLM pubblici utilizzano centinaia di miliardi (a volte trilioni) di variabili per comprendere gli input dell'utente e decidere una risposta adeguata. D'altra parte, i modelli linguistici più piccoli, come Phi-3 di Microsoft, utilizzano solo 3,8 miliardi di parametri, mentre Google Gemma ne vanta 2 miliardi. Tuttavia, grazie all'approccio unico di OpenELM all'architettura del modello di trasformatore, il modello si ferma a soli 270 milioni di parametri.

Ovviamente, ci sono alcuni aspetti negativi nell'essere piccoli. Per prima cosa, OpenELM non è multimodale, avendo un numero di parametri troppo basso per essere fattibile. Inoltre, la sua conoscenza fattuale è piuttosto bassa, come dimostrato dal rapporto tecnico https://www.google.com/url?sa=t&source=web&rct=j&opi=89978449&url=https://arxiv.org/abs/2404.14619&ved=2ahUKEwjthIWbmeyFAxXMXEEAHeVICrgQFnoECBQQAQ&usg=AOvVaw0lkrTbxKNgbdUB4po5zOEa . Questo problema affligge tutti i LLM pubblici di dimensioni simili. Tuttavia, le dimensioni ridotte consentono al modello AI di essere ospitato localmente su telefoni o computer portatili, anziché sul cloud.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones

Appleil rilascio pubblico di OpenELM da parte dell'azienda rappresenta una svolta rispetto alle pratiche tipiche dell'azienda. Dal quadro completo e dalla valutazione del modello, ai registri di addestramento, alle configurazioni di pre-addestramento e al codice di inferenza MLX, ogni aspetto del modello linguistico è pubblicamente disponibile tramite Hugging Face, affinché gli sviluppatori possano modificarlo e riutilizzarlo per diversi casi d'uso. In apparenza, un rilascio così esteso dovrebbe rafforzare la partecipazione di Apple all'AI, ispirando i ricercatori a giocare con le possibilità dei dispositivi Apple.

Ma ci sono altri attori in questo spazio. Phi-3 di Microsoft è un rivale molto competente, così come gli altri progetti LLM aperti di Redmond. Gemma 2B - 3B di Google è un altro. Sebbene tutti i modelli citati funzionino ancora troppo lentamente, l'hardware e il software si stanno certamente muovendo nelle giuste direzioni per i modelli linguistici di piccole dimensioni.

Per ora, i dispositivi edge come Samsung Galaxy S24 (a partire da 799 dollari su Amazon), o il OnePlus 12R che utilizza il sistema interno Andes-GPT devono affidarsi all'elaborazione nel cloud. Indipendentemente dal fatto che Apple incorpori o meno OpenELM nel prossimo iPhone, è probabile che l'azienda di Cupertino collaborerà con Google o Open AI per le funzioni di AI generativa più pesanti.